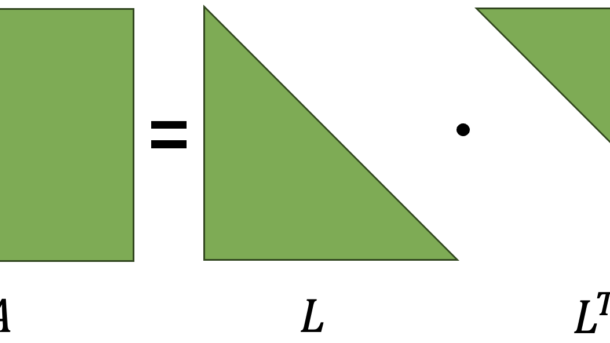

Ya han transcurrido varios años desde el inicio del auge del Deep Learning. He sido testigo de logros impresionantes como ChatGPT y Midjourney, sin embargo, aún me sorprende cómo métodos tradicionales como la descomposición Cholesky siguen siendo extremadamente útiles y eficientes. En particular, para tareas como la Regresión Lineal, este...

Seguir leyendo...tensorflow

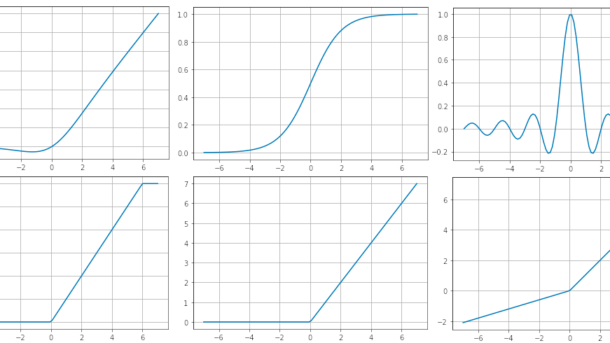

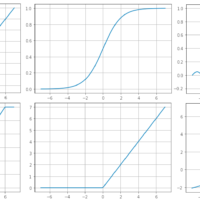

Funciones de Activación

Tabla de Contenidos ¿Qué es una función de activación? Funciones de Activación Sigmoide ReLU (Rectified Linear Unit) ReLU6 Tangente Hiperbólica ELU (Exponential Linear Unit) Softmax Softplus Softsign Swish Sinc Leaky ReLU Mish GELU (Gaussian Error Linear Unit) SELU (Scaled Exponential Linear Unit) ¿Qué es una función de activación? Una función...

Seguir leyendo...