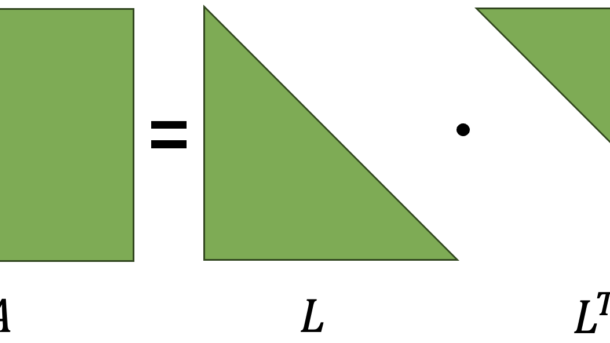

Ya han transcurrido varios años desde el inicio del auge del Deep Learning. He sido testigo de logros impresionantes como ChatGPT y Midjourney, sin embargo, aún me sorprende cómo métodos tradicionales como la descomposición Cholesky siguen siendo extremadamente útiles y eficientes. En particular, para tareas como la Regresión Lineal, este...

Seguir leyendo...Inteligencia Artificial

Transformadores: ¿cómo funcionan internamente?

Tabla de contenidos Introducción El Transformador es actualmente una de las arquitecturas más populares para el Procesamiento del Lenguaje Natural (NLP). Periódicamente, podemos escuchar noticias sobre nuevas arquitecturas y modelos basados en transformadores que generan mucho interés y expectativas en la comunidad. Google Research y miembros de Google Brain propusieron...

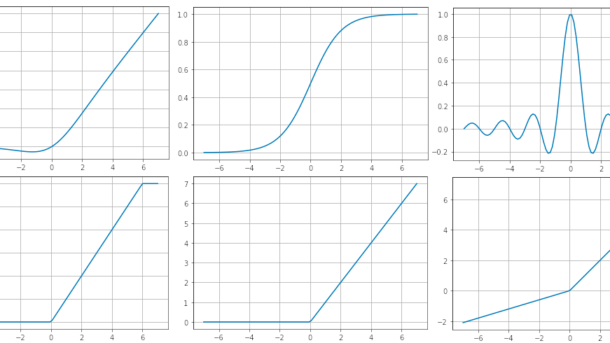

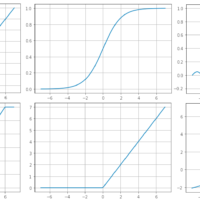

Seguir leyendo...Funciones de Activación

Tabla de Contenidos ¿Qué es una función de activación? Funciones de Activación Sigmoide ReLU (Rectified Linear Unit) ReLU6 Tangente Hiperbólica ELU (Exponential Linear Unit) Softmax Softplus Softsign Swish Sinc Leaky ReLU Mish GELU (Gaussian Error Linear Unit) SELU (Scaled Exponential Linear Unit) ¿Qué es una función de activación? Una función...

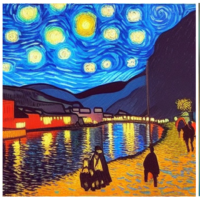

Seguir leyendo...Generadores de Imágenes-¿Qué valor tiene StableDifussion en éste contexto?

La generación automática de imágenes es una de las tareas que actualmente ha sido potenciada por generadores de imágenes potenciados por Inteligencia Artificial (AI). Estos últimos días se ha estado hablado mucho sobre StableDiffusion, que es un modelo generador de imágenes como varios que existen actualmente, y que no tiene nada que envidiar a los demás.

Seguir leyendo...